NVIDIA Vera Rubin brise le moule des GPU avec des racks de 600 kilowatts et des mémoires d'un million de jetons.

Jensen Huang, CEO de NVIDIA, a lâché une bombe lors de la GTC 2025, ce qui a fait bondir les équipes chargées de l'infrastructure : la plate-forme Vera Rubin fera passer les baies des centres de données à 600 kilowatts d'ici 2027.¹ Cette annonce marque un changement fondamental dans le mode de fonctionnement des centres de données, obligeant à repenser complètement l'alimentation électrique, les systèmes de refroidissement et l'infrastructure physique qui sont restés pratiquement inchangés depuis des dizaines d'années.

La plate-forme Vera Rubin représente l'avancée la plus ambitieuse de NVIDIA à ce jour. Ce système multi-composants associe le CPU personnalisé Vera, le GPU Rubin de nouvelle génération et l'accélérateur spécialisé Rubin CPX (Context Processing eXtension), conçu spécifiquement pour les charges de travail d'IA d'un million de clés.² Contrairement aux améliorations incrémentales typiques des générations de GPU, la variante Vera Rubin NVL144 CPX apporte 7,5 fois plus de performances d'IA que les systèmes Blackwell GB300 actuels, tout en changeant fondamentalement la façon dont les GPU sont emballés, refroidis et déployés.³

" Nous sommes la première entreprise technologique de l'histoire à avoir annoncé quatre générations de quelque chose ", a expliqué Huang à Data Center Dynamics, en exposant la feuille de route de NVIDIA jusqu'en 2028.⁴ La transparence sert un objectif essentiel : donner aux fournisseurs d'infrastructures, aux opérateurs de centres de données et aux entreprises comme Introl le délai nécessaire pour se préparer à ce qui s'apparente à une réimagination complète de l'infrastructure de l'IA.

Les spécifications de la plate-forme NVIDIA Vera Rubin NVL144 indiquent des performances d'inférence FP4 de 3,6 exaflops et une amélioration de 3,3 fois par rapport à la plate-forme GB300 NVL72, qui arrivera au second semestre 2026.

La révolution de l'architecture commence avec le silicium personnalisé.

La feuille de route complète de NVIDIA, de Blackwell à Feynman, montrant l'évolution d'Oberon aux architectures de rack Kyber supportant une consommation d'énergie allant jusqu'à 600 kW.

Le CPU Vera marque l'abandon par NVIDIA des conceptions ARM standard, avec 88 cœurs ARM personnalisés avec multithreading simultané, ce qui permet d'obtenir 176 processeurs logiques.⁵ NVIDIA appelle ces cœurs personnalisés " Olympus " et leur conception permet de doubler les performances du CPU Grace utilisé dans les systèmes Blackwell actuels.⁶ Chaque CPU Vera se connecte aux GPU Rubin via une interface NVLink C2C de 1,8 To/s, ce qui permet une bande passante sans précédent entre les éléments de calcul.⁷

Le GPU Rubin standard repousse les limites avec 288 Go de mémoire HBM4 par boîtier, conservant la même capacité que le Blackwell Ultra B300 mais augmentant de 8 TB/s à 13 TB/s la bande passante de la mémoire.Chaque package Rubin contient deux GPU dies limités par des réticules, bien que NVIDIA ait changé sa méthodologie de comptage - ce que Blackwell appelait un GPU (deux dies), Rubin l'appelle deux GPU.⁹ Ce changement reflète la complexité croissante des architectures multi-die et aide les clients à mieux comprendre les ressources de calcul réelles dans chaque système.

L'élément le plus innovant se présente sous la forme du Rubin CPX, un accélérateur spécialement conçu pour le traitement de contextes massifs. La conception monolithique fournit 30 petaFLOPs de calcul NVFP4 avec 128 Go de mémoire GDDR7 économique, spécifiquement optimisée pour les mécanismes d'attention dans les modèles de transformateurs.¹⁰ Le CPX atteint des capacités d'attention trois fois plus rapides par rapport aux systèmes NVL72 GB300, permettant aux modèles d'IA de traiter des contextes de millions de jetons - équivalents à une heure de vidéo ou à des bases de code entières - sans dégradation des performances.¹¹

Le déploiement exige une refonte complète de l'infrastructure.

Le système standard Vera Rubin NVL144, dont l'arrivée est prévue pour le second semestre 2026, reste compatible avec l'infrastructure GB200/GB300 existante, en utilisant l'architecture de rack familière Oberon.¹² Le système contient 144 matrices GPU (72 paquets), 36 CPU Vera, et fournit 3,6 exaFLOPS de performance d'inférence FP4 - une amélioration de 3,3 fois par rapport à Blackwell Ultra.¹³ La consommation d'énergie reste gérable à environ 120-130kW par rack, similaire aux déploiements actuels.

La variante Vera Rubin NVL144 CPX va encore plus loin en intégrant 144 GPU Rubin CPX aux côtés de 144 GPU Rubin standard et 36 CPU Vera pour fournir huit exaFLOPs de calcul NVFP4, soit une amélioration de 7,5 fois par rapport à la NVL72 GB300, avec 100 To de mémoire à grande vitesse et 1,7 PB/s de bande passante mémoire dans un seul rack.¹⁴

Tout change avec Rubin Ultra et l'architecture de rack Kyber en 2027. Le système NVL576 concentre 576 processeurs graphiques dans un seul rack, consommant 600 kW d'énergie, soit cinq fois plus que les systèmes actuels.¹⁵ La conception Kyber fait pivoter les lames de calcul de 90 degrés vers une orientation verticale, empaquetant quatre pods de 18 lames chacun dans le rack.¹⁶ Chaque lame abrite huit GPU Rubin Ultra aux côtés des CPU Vera, atteignant ainsi des densités qui semblaient impossibles il y a quelques années seulement.

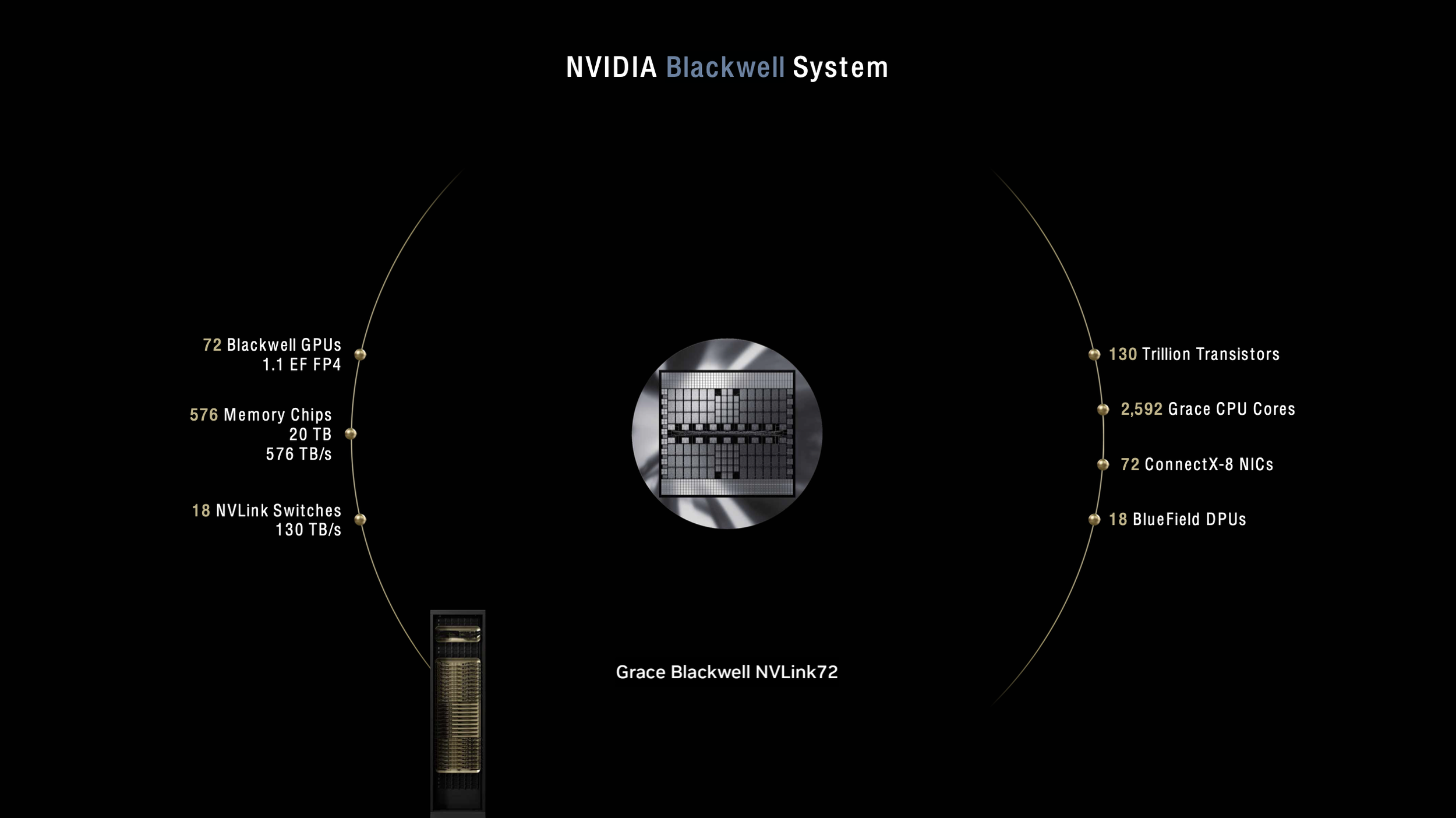

Système NVIDIA Blackwell actuel avec 72 GPU délivrant 1,1 exaflops

Le futur système NVIDIA Rubin peut atteindre 576 GPU et 15 exaflops dans un seul rack de 600 kW.

Le refroidissement de ces systèmes nécessite une immersion complète dans un liquide sans aucun ventilateur, ce qui diffère des systèmes actuels qui utilisent encore un refroidissement par air pour les composants auxiliaires.¹⁷ CoolIT Systems et Accelsius ont déjà démontré des solutions de refroidissement capables de gérer des racks de 250 kW avec des températures d'eau d'entrée de 40°C, validant ainsi la voie technologique vers les déploiements de 600 kW.¹⁸ Le rack Kyber comprend un wagon latéral dédié à l'infrastructure d'alimentation et de refroidissement, nécessitant effectivement deux empreintes de rack pour chaque système de 600 kW.¹⁹

L'évolution de l'architecture de puissance permet des calculs à l'échelle du mégawatt.

La transition de NVIDIA vers une distribution d'énergie de 800 VDC répond aux limites physiques fondamentales de l'infrastructure actuelle. La distribution traditionnelle de 54V dans le rack nécessiterait 64U d'étagères d'alimentation pour les systèmes Kyber-scale, ne laissant pas de place pour le calcul réel.²⁰ L'architecture 800V élimine la conversion AC/DC au niveau du rack, améliore l'efficacité de bout en bout jusqu'à 5%, et réduit les coûts de maintenance jusqu'à 70%.²¹

La nouvelle infrastructure électrique prend en charge des racks allant de 100 kW à plus de 1 MW, en utilisant le même backbone, et fournit l'évolutivité nécessaire pour les générations futures.²² Les entreprises qui déploient Vera Rubin doivent prévoir des mises à niveau électriques massives - un seul rack NVL576 consomme autant d'énergie que 400 maisons typiques. Les centres de données qui prévoient des déploiements en 2027 devraient commencer dès maintenant à mettre à niveau leur infrastructure, y compris les connexions électriques à l'échelle de l'entreprise et éventuellement la production sur site.

Pour les spécialistes de l'infrastructure comme Introl, ce changement crée des opportunités sans précédent. L'expertise de l'entreprise dans le déploiement d'infrastructures GPU à grande échelle, la gestion de plus de 100 000 GPU dans le monde et sa présence étendue dans la région Asie-Pacifique lui permettent de se positionner comme un acteur de premier plan dans le domaine de l'infrastructure GPU. sa présence étendue dans la région APAC Les organisations ont besoin de partenaires qui comprennent non seulement le déploiement des GPU, mais aussi la danse complexe de l'alimentation, du refroidissement et du réseau requise pour les systèmes de 600 kW.

Les gains de performance justifient les investissements dans les infrastructures.

La variante NVL144 CPX de Vera Rubin illustre le potentiel de la plate-forme avec ses huit exaFLOPS de calcul NVFP4, ainsi que 100 To de mémoire à haut débit et 1,7 Po/s de bande passante mémoire, le tout dans un seul rack.²⁴ NVIDIA affirme que les entreprises peuvent obtenir un retour sur investissement de 30 à 50 fois, soit 5 milliards de dollars de chiffre d'affaires pour un investissement de 100 millions de dollars.²⁵

Parmi les premiers utilisateurs, on peut citer le centre de supercalcul Leibniz en Allemagne, qui déploie le supercalculateur Blue Lion avec Vera Rubin pour obtenir une puissance de calcul 30 fois supérieure à celle de son système actuel.²⁶ Le système Doudna du Lawrence Berkeley National Lab fonctionnera également avec Vera Rubin, combinant la simulation, les données et l'IA en une seule plateforme de calcul scientifique.²⁷

La spécialisation du Rubin CPX pour le traitement du contexte s'attaque à un goulot d'étranglement critique dans les systèmes d'IA actuels. Des entreprises comme Cursor, Runway et Magic explorent déjà la manière dont le CPX peut accélérer les assistants de codage et les applications de génération vidéo qui nécessitent le traitement simultané de millions de jetons.²⁸ La capacité de maintenir des bases de code entières ou des heures de vidéo dans la mémoire active change fondamentalement ce que les applications d'IA peuvent réaliser.

Les problèmes d'infrastructure créent des opportunités de marché.

Le passage à des baies de 600 kW met en lumière de dures réalités concernant les capacités actuelles des centres de données. La plupart des installations se débattent avec des baies de 40 kW ; même les centres de données d'IA de pointe dépassent rarement 120 kW. La transition nécessite non seulement de nouveaux systèmes de refroidissement, mais aussi une refonte complète des installations, depuis les sols en béton capables de supporter des charges massives jusqu'aux sous-stations électriques dimensionnées pour des opérations industrielles.

"La question reste de savoir combien de centres de données existants seront en mesure de supporter une configuration aussi dense", note The Register, soulignant que la nature personnalisée des racks Kyber signifie que les installations ont besoin d'une infrastructure spécifique.²⁹ Les nouveaux développements dans les régions disposant d'un surplus d'énergie renouvelable ou nucléaire - la Scandinavie, le Québec et les Émirats arabes unis - conduiront probablement à l'adoption de ces systèmes.³⁰

Ce calendrier donne à l'industrie une certaine marge de manœuvre, mais exige des mesures immédiates. Les organisations qui prévoient une infrastructure d'IA pour 2027 et au-delà doivent prendre des décisions dès maintenant concernant l'emplacement des installations, l'approvisionnement en énergie et l'architecture de refroidissement. Le délai de trois ans reflète la complexité du déploiement d'une infrastructure qui fonctionne à la limite de ce qui est physiquement possible.

La route au-delà de Vera Rubin

La feuille de route de NVIDIA va au-delà de Vera Rubin jusqu'à l'architecture Feynman en 2028, ce qui devrait conduire à des baies d'un mégawatt.³¹ Giordano Albertazzi, PDG de Vertiv, estime que pour atteindre une densité de l'ordre du MW, il faudra "une nouvelle révolution dans le refroidissement liquide et un changement de paradigme du côté de l'alimentation".³² La trajectoire semble inévitable : les charges de travail de l'intelligence artificielle exigent des augmentations exponentielles de la densité de calcul et l'économie favorise la concentration plutôt que la distribution.

Le passage d'améliorations incrémentales à des changements révolutionnaires dans l'infrastructure GPU reflète la transformation plus large de l'IA. Tout comme les grands modèles de langage sont passés de milliards à des trillions de paramètres, l'infrastructure qui les prend en charge doit faire des bonds similaires. Vera Rubin ne représente pas seulement des GPU plus rapides, mais une refonte fondamentale du fonctionnement de l'infrastructure de calcul.

Pour des entreprises comme Introl, spécialisées dans le déploiement d'infrastructures GPU, Vera Rubin crée une opportunité générationnelle. Les entreprises ont besoin de partenaires capables de gérer la complexité des déploiements de 600 kW, de la planification initiale à la mise en œuvre et à l'optimisation continue. Les entreprises qui parviendront à déployer Vera Rubin bénéficieront d'avantages concurrentiels significatifs en matière de capacités d'IA, tandis que celles qui hésiteront risquent de perdre du terrain dans la course à l'IA exascale que se livrera l'industrie.

Conclusion

La plate-forme Vera Rubin de NVIDIA oblige l'industrie des centres de données à affronter des vérités gênantes sur les limites de l'infrastructure tout en offrant des capacités de calcul sans précédent. Les racks de 600 kW de 2027 représentent bien plus qu'une simple augmentation de la consommation d'énergie : ils marquent une transformation complète de la manière dont l'infrastructure d'IA est construite, refroidie et exploitée. Les organisations qui commencent à planifier dès maintenant, en s'associant à des spécialistes de l'infrastructure expérimentés qui comprennent les complexités des déploiements de nouvelle génération, seront les mieux placées pour exploiter les capacités révolutionnaires offertes par Vera Rubin.

L'arrivée de la plateforme en 2026-2027 donne à l'industrie le temps de se préparer, mais le temps presse. Les centres de données conçus aujourd'hui doivent anticiper les besoins de demain, et Vera Rubin indique clairement que demain exigera des changements radicaux par rapport à la pensée conventionnelle. Les entreprises qui adopteront cette transformation seront à l'origine de la prochaine génération de percées dans le domaine de l'IA, qu'il s'agisse de modèles linguistiques d'un million de mots ou de systèmes de génération de vidéos en temps réel, qui semblent aujourd'hui relever de la science-fiction.

Références

¹ The Register. "Vera Rubin de Nvidia CPU, GPUs chart course for 600kW racks". 19 mars 2025. https://www.theregister.com/2025/03/19/nvidia_charts_course_for_600kw.

² Salle de presse de NVIDIA. "NVIDIA dévoile Rubin CPX : une nouvelle classe de GPU conçue pour l'inférence de contextes massifs. 2025. https://nvidianews.nvidia.com/news/nvidia-unveils-rubin-cpx-a-new-class-of-gpu-designed-for-massive-context-inference.

Ibid.

⁴ Data Center Dynamics. "GTC : Jensen Huang, Ian Buck et Charlie Boyle de Nvidia sur l'avenir de la densité des racks des centres de données. 21 mars 2025. https://www.datacenterdynamics.com/en/analysis/nvidia-gtc-jensen-huang-data-center-rack-density/.

⁵ TechPowerUp. "NVIDIA dévoile le CPU Vera et le GPU Rubin Ultra AI, et annonce l'architecture Feynman. 2025. https://www.techpowerup.com/334334/nvidia-unveils-vera-cpu-and-rubin-ultra-ai-gpu-announces-feynman-architecture.

⁶ CNBC. "Nvidia annonce les puces d'IA Blackwell Ultra et Vera Rubin". 18 mars 2025. https://www.cnbc.com/2025/03/18/nvidia-announces-blackwell-ultra-and-vera-rubin-ai-chips-.html.

Yahoo Finance. "Nvidia présente la nouvelle génération de superpuces Vera Rubin à la GTC 2025". 18 mars 2025. https://finance.yahoo.com/news/nvidia-debuts-next-generation-vera-rubin-superchip-at-gtc-2025-184305222.html.

⁸ Plate-forme suivante. "Nvidia Draws GPU System Roadmap Out To 2028 (Nvidia dessine une feuille de route pour les systèmes GPU jusqu'en 2028). 5 juin 2025. https://www.nextplatform.com/2025/03/19/nvidia-draws-gpu-system-roadmap-out-to-2028/.

⁹ SemiAnalysis. "NVIDIA GTC 2025 - Built For Reasoning, Vera Rubin, Kyber, CPO, Dynamo Inference, Jensen Math, Feynman". 4 août 2025. https://semianalysis.com/2025/03/19/nvidia-gtc-2025-built-for-reasoning-vera-rubin-kyber-cpo-dynamo-inference-jensen-math-feynman/.

Salle de presse de NVIDIA. "NVIDIA dévoile Rubin CPX : une nouvelle classe de GPU conçue pour l'inférence massive de contexte.

¹¹ Ibid.

¹² Tom's Hardware. "Nvidia annonce des GPU Rubin en 2026, Rubin Ultra en 2027, Feynman également ajouté à la feuille de route". 18 mars 2025. https://www.tomshardware.com/pc-components/gpus/nvidia-announces-rubin-gpus-in-2026-rubin-ultra-in-2027-feynam-after.

¹³ La nouvelle pile. "NVIDIA dévoile les architectures Rubin et Feynman de nouvelle génération, repoussant les limites de puissance de l'IA. 14 avril 2025. https://thenewstack.io/nvidia-unveils-next-gen-rubin-and-feynman-architectures-pushing-ai-power-limits/.

Salle de presse de NVIDIA. "NVIDIA dévoile Rubin CPX : une nouvelle classe de GPU conçue pour l'inférence massive de contexte.

¹⁵ Data Center Dynamics. "Le rack Rubin Ultra NVL576 de Nvidia devrait être de 600kW, et arrivera dans la seconde moitié de 2027." 18 mars 2025. https://www.datacenterdynamics.com/en/news/nvidias-rubin-ultra-nvl576-rack-expected-to-be-600kw-coming-second-half-of-2027/.

¹⁶ Tom's Hardware. "Nvidia montre le Rubin Ultra avec des racks et une infrastructure Kyber de 600 000 watts, à venir en 2027". 19 mars 2025. https://www.tomshardware.com/pc-components/gpus/nvidia-shows-off-rubin-ultra-with-600-000-watt-kyber-racks-and-infrastructure-coming-in-2027.

¹⁷ Data Center Dynamics. "GTC : Jensen Huang, Ian Buck et Charlie Boyle de Nvidia sur l'avenir de la densité des racks des centres de données.

¹⁸ Data Center Frontier. "CoolIT et Accelsius repoussent les limites du refroidissement liquide dans les centres de données alors que la densité des baies augmente. 2025. https://www.datacenterfrontier.com/cooling/article/55281394/coolit-and-accelsius-push-data-center-liquid-cooling-limits-amid-soaring-rack-densities.

¹⁹ Data Center Dynamics. "GTC : Jensen Huang, Ian Buck et Charlie Boyle de Nvidia sur l'avenir de la densité des racks des centres de données.

²⁰ Blog technique de NVIDIA. " L'architecture NVIDIA 800 VDC alimentera la prochaine génération d'usines d'IA ". 20 mai 2025. https://developer.nvidia.com/blog/nvidia-800-v-hvdc-architecture-will-power-the-next-generation-of-ai-factories/.

²¹ Ibid.

²² Ibid.

²³ Introl. "Zone de couverture". Consulté en 2025. https://introl.com/coverage-area.

²⁴ NVIDIA Newsroom. "NVIDIA dévoile Rubin CPX : une nouvelle classe de GPU conçue pour l'inférence massive de contexte.

²⁵ Ibid.

²⁶ NVIDIA Blog. "Le supercalculateur Blue Lion fonctionnera avec NVIDIA Vera Rubin. 10 juin 2025. https://blogs.nvidia.com/blog/blue-lion-vera-rubin/.

²⁷ Ibid.

²⁸ NVIDIA Newsroom. "NVIDIA dévoile Rubin CPX : une nouvelle classe de GPU conçue pour l'inférence massive de contexte.

²⁹ The Register. "Le processeur Vera Rubin de Nvidia, les GPU tracent la voie vers des baies de 600 kW".

³⁰ Global Data Center Hub. "Les baies de 600 kW de Nvidia sont là (votre infrastructure est-elle prête ?). 23 mars 2025. https://www.globaldatacenterhub.com/p/issue-8-nvidias-600kw-racks-are-hereis.

³¹ TechPowerUp. "NVIDIA dévoile le CPU Vera et le GPU Rubin Ultra AI, et annonce l'architecture Feynman.

Dynamique des centres de données. "GTC : Jensen Huang, Ian Buck et Charlie Boyle de Nvidia sur l'avenir de la densité des racks des centres de données".