La révolution Computex 2025 de NVIDIA : Transformer les centres de données en usines d'IA

Jensen Huang, CEO de NVIDIA, est monté sur scène au Computex 2025, vêtu de sa veste en cuir caractéristique, et a dévoilé un nouveau matériel ainsi qu'un paradigme informatique entièrement réimaginé. Le géant des semi-conducteurs s'est résolument transformé en une société d'infrastructure de l'IA, jetant les bases de ce que M. Huang appelle "l'infrastructure de l'intelligence", la troisième grande révolution de l'infrastructure après l'électricité et l'internet.

Cette keynote n'était pas une simple annonce de produit - c'était Jensen qui présentait le plan de NVIDIA pour remodeler le paysage informatique. Les sauts techniques, les pivots stratégiques et les jeux de marché qu'il a révélés feront probablement de ce Computex celui dont nous nous souviendrons pendant des années. Regarder l'intégralité de la présentation de Nvidia Computex 2025 de Nvidia.

L'évolution stratégique de NVIDIA : Des cartes graphiques au fournisseur d'infrastructure

L'histoire de la transformation de NVIDIA est époustouflante. En 1993, M. Jensen a vu une "opportunité de puce de 300 millions de dollars", un marché substantiel. Aujourd'hui, il est à la tête d'une infrastructure d'IA d'une valeur de plusieurs billions de dollars. Ce type de croissance explosive n'est pas le fruit du hasard : NVIDIA s'est fondamentalement réinventée à plusieurs reprises en cours de route.

Au cours de son discours, M. Jensen a souligné les tournants qui ont permis à NVIDIA d'exister aujourd'hui :

2006: CUDA débarque et bouleverse l'informatique parallèle. Soudain, des développeurs qui n'avaient jamais envisagé d'utiliser les GPU pour le calcul général ont créé des applications qui auraient été impossibles à réaliser avec des CPU traditionnels.

2016: Le DGX1 est devenu le premier système sans compromis de NVIDIA, axé sur l'IA. Dans ce qui apparaît aujourd'hui comme une étrange anticipation, Jensen a fait don de la première unité à OpenAI, lui donnant ainsi les bases de calcul qui allaient conduire à la révolution de l'IA que nous connaissons aujourd'hui.

2019: Acquisition de Mellanox, permettant à NVIDIA de reconceptualiser les centres de données en tant qu'unités informatiques unifiées.

Cette transformation aboutit à la position actuelle de NVIDIA en tant que " société d'infrastructure essentielle " - un statut que Huang a souligné en mettant en avant ses feuilles de route publiques quinquennales sans précédent, qui permettent de planifier l'infrastructure mondiale pour le déploiement de l'IA.

Redéfinir les indicateurs de performance : L'économie des jetons

NVIDIA a introduit un changement fondamental dans la façon dont nous mesurons le rendement informatique. Plutôt que les mesures traditionnelles telles que les FLOP ou les opérations par seconde, M. Huang a positionné les centres de données d'IA comme des usines produisant des " jetons ", c'est-à-dire des unités d'intelligence informatique :

"Les entreprises commencent à parler du nombre de jetons qu'elles ont produits au cours du dernier trimestre et du nombre de jetons qu'elles ont produits au cours du dernier mois. Très bientôt, nous parlerons du nombre de jetons que nous produisons chaque heure, comme le font toutes les usines."

Ce recadrage établit un lien direct entre l'investissement informatique et les résultats commerciaux, en alignant l'infrastructure de l'IA sur les cadres industriels traditionnels. Ce modèle positionne NVIDIA à l'épicentre d'un nouveau paradigme économique où l'efficacité informatique se traduit directement par des capacités commerciales.

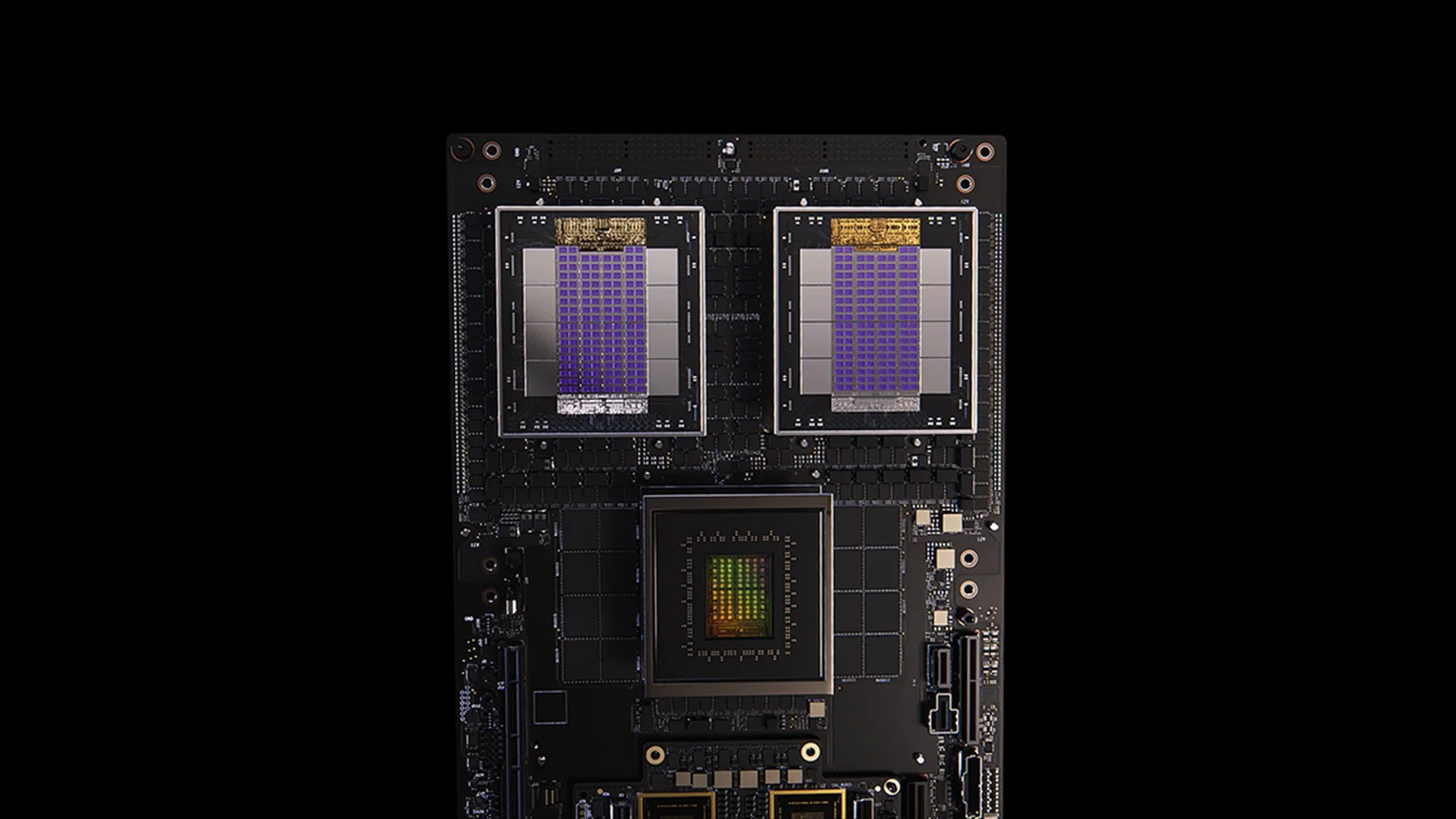

Mises à niveau de l'architecture Blackwell : Spécifications et mesures de performance du GB300

Système GB200

La mise à jour GB300 de l'architecture Blackwell illustre le cycle d'amélioration continue des performances de NVIDIA. Prévue pour le troisième trimestre 2025, la GB300 apporte :

1,5 fois plus de performances d'inférence par rapport au GB200

Augmentation de la capacité de mémoire HBM de 1,5 fois

Amélioration de la bande passante du réseau de 2x

Conception entièrement refroidie par liquide

Rétrocompatibilité avec les châssis et systèmes existants

Chaque nœud GB300 délivre environ 40 pétaflops, remplaçant ainsi la totalité du supercalculateur Sierra (vers 2018), qui nécessitait 18 000 GPU Volta. Ce gain de performance de 4000 fois en six ans dépasse largement l'échelle traditionnelle de la loi de Moore, démontrant l'approche multi-facettes de NVIDIA pour l'accélération des performances grâce à des innovations en matière d'architecture, de logiciel et d'interconnexion.

MVLink : Redéfinir la technologie d'interconnexion

MVLink représente l'avancée la plus importante dans la technologie d'interconnexion des GPU depuis l'introduction de NVLink. Le système permet une désagrégation complète des ressources de calcul à travers un rack entier, transformant 72 GPU (144 GPU dies) en une seule unité de calcul massive.

Les spécifications techniques sont stupéfiantes :

Commutateurs individuels MVLink : Largeur de bande de 7,2 TB/s

MVLink spine : 130 To/s de bande passante de bout en bout

Mise en œuvre physique : 5 000 câbles coaxiaux dont la longueur est précisément adaptée (environ 2 miles au total).

Densité de puissance : 120 kilowatts par rack (nécessitant un refroidissement liquide)

Pour situer le contexte, M. Huang a fait remarquer que le trafic de pointe de l'ensemble de l'internet est d'environ 900 térabits par seconde (112,5 TB/s), ce qui fait qu'une seule colonne vertébrale MVLink est capable de gérer un trafic supérieur à celui de l'internet mondial à sa capacité maximale.

MVLink Fusion : Création d'un écosystème ouvert d'infrastructure d'IA

MVLink Fusion est peut-être l'initiative la plus innovante de NVIDIA en matière d'écosystème depuis des années. Au lieu d'obliger ses partenaires à utiliser du matériel NVIDIA, la société ouvre l'architecture pour permettre aux entreprises de construire des systèmes d'IA semi-personnalisés qui s'intègrent dans l'univers NVIDIA.

L'approche est étonnamment flexible :

Intégration d'ASIC sur mesure: Vous avez un accélérateur spécialisé ? Pas de problème. Les partenaires peuvent déposer des chiplets MVLink pour connecter leur silicium personnalisé à l'écosystème de NVIDIA. C'est comme si NVIDIA disait : " Construisez le matériel spécialisé que vous voulez, mais assurez-vous qu'il peut communiquer avec nos produits.

Intégration d'unités centrales personnalisées: Les fournisseurs de processeurs ne sont pas en reste. Ils peuvent directement mettre en œuvre les interfaces puce à puce de MVLink, créant ainsi une autoroute directe entre leurs processeurs et les GPU Blackwell (ou l'architecture Ruben à venir). MVLink est un atout majeur pour les entreprises qui ont investi dans des architectures de processeurs spécifiques.

Les annonces de partenaires couvrent l'ensemble de l'industrie des semi-conducteurs :

Partenaires de mise en œuvre du silicium : LCHIP, Astera Labs, Marll, MediaTek

Fournisseurs de CPU : Fujitsu, Qualcomm

Fournisseurs d'EDA : Cadence, Synopsis

Cette approche permet à NVIDIA de se positionner stratégiquement pour capter de la valeur quelle que soit la combinaison matérielle spécifique déployée par les clients, ce qui reflète la déclaration candide de Huang : " Rien ne me réjouit plus que lorsque vous achetez tout chez NVIDIA " : "Rien ne me fait plus plaisir que lorsque vous achetez tout chez NVIDIA. Je veux que vous le sachiez. Mais je me réjouis énormément si vous achetez quelque chose à NVIDIA."

Déploiement de l'IA en entreprise : RTX Pro Enterprise et Omniverse Server

Le RTX Pro Enterprise et le serveur Omniverse représentent la plus importante offre de calcul de NVIDIA axée sur les entreprises, conçue spécifiquement pour intégrer les capacités d'IA dans les environnements informatiques traditionnels :

Architecture entièrement compatible avec x86

Prise en charge des hyperviseurs traditionnels (VMware, Red Hat, Nanix)

Intégration de Kubernetes pour une orchestration familière de la charge de travail.

GPU Blackwell RTX Pro 6000s (8 par serveur)

Puce réseau CX8 offrant une bande passante de 800 Gb/s

Amélioration des performances de 1,7 fois par rapport au Hopper H100

Performances multipliées par 4 sur les modèles optimisés tels que Deepseek R1

Le système établit une nouvelle enveloppe de performance pour l'inférence de l'IA, mesurée dans un cadre à deux axes de débit (jetons par seconde) et de réactivité (jetons par seconde par utilisateur) - des mesures essentielles pour ce que Huang décrit comme l'ère de "l'échelonnement du temps d'inférence" ou de "l'IA pensante".

Plateforme de données IA : Réimaginer le stockage des données non structurées

L'AI Data Platform de NVIDIA introduit une approche fondamentalement différente du stockage d'entreprise :

"Les humains interrogent des bases de données structurées comme SQL... Mais l'IA veut interroger des données non structurées. Elle veut du sémantique. Elle veut du sens. Nous devons donc créer un nouveau type de plateforme de stockage".

Les principaux éléments sont les suivants

NVIDIA AIQ (ou IQ) : Une couche d'interrogation sémantique

Les nœuds de stockage accélérés par le GPU remplacent les architectures traditionnelles centrées sur le CPU

Modèles d'IA post-entraînés avec provenance transparente des données d'entraînement

Interrogation 15 fois plus rapide avec des résultats améliorés de 50 % par rapport aux solutions existantes

Les partenaires du secteur du stockage qui mettent en œuvre cette architecture sont Dell, Hitachi, IBM, NetApp et Vast, créant ainsi un écosystème complet de gestion des données d'IA pour les entreprises.

Opérations d'IA et robotique : Cadres logiciels pour l'entreprise intelligente

Le discours inaugural a permis de présenter deux cadres logiciels essentiels :

Opérations d'IA (AIOps): Une pile complète pour gérer les agents d'IA dans les contextes d'entreprise, y compris la curation des données, l'affinage des modèles, l'évaluation, les garde-fous et la sécurité. Les partenaires incluent Crowdstrike, Data IQ, Data Robots, Elastic, Newonix, Red Hat et Trend Micro.

Isaac Groot Platform N1.5: un écosystème de développement robotique à source ouverte comprenant :

Moteur physique Newton (développé avec Google DeepMind et Disney Research)

Processeur robotique Jetson Thor

Système d'exploitation NVIDIA Isaac

Groot Dreams : schéma directeur pour la génération de données synthétiques sur les trajectoires

L'initiative en matière de robotique relève un défi majeur : "Pour que la robotique puisse voir le jour, il faut de l'IA. Mais pour enseigner l'IA, il faut de l'IA". Ce modèle d'optimisation récursive s'appuie sur l'IA générative pour transformer des données de démonstration humaines limitées en ensembles complets de formation à la robotique.

Position stratégique de Taïwan dans la révolution manufacturière de l'IA

Une grande partie de la conférence a mis en évidence le rôle central de Taïwan dans la production et la mise en œuvre des technologies de l'IA :

Les entreprises de fabrication taïwanaises (TSMC, Foxconn, Wistron, Pegatron, Delta Electronics, Quanta, Wiiwin, Gigabyte) déploient NVIDIA Omniverse pour les implémentations de jumeaux numériques.

TSMC utilise des outils alimentés par l'IA sur CUDA pour optimiser l'agencement des usines et les systèmes de tuyauterie.

Les partenaires industriels utilisent les jumeaux numériques pour la planification virtuelle et la maintenance prédictive, ainsi que comme "salles de sport pour robots" pour l'entraînement des systèmes robotiques.

Foxconn, TSMC, le gouvernement taïwanais et NVIDIA construisent le premier superordinateur d'IA à grande échelle de Taïwan.

M. Huang a encore renforcé l'engagement de NVIDIA dans la région en annonçant des plans pour " NVIDIA Constellation ", un nouveau siège social à Taipei.

Analyse technique : Ce que cela signifie pour la stratégie d'IA des entreprises

L'ensemble de ces annonces représente une réorganisation complète de l'informatique d'entreprise avec plusieurs implications stratégiques :

Exigences en matière d'échelle de calcul: Les exigences de performance en matière d'inférence de l'"IA raisonnante" et des systèmes agentiques entraîneront des besoins de calcul nettement plus élevés que les déploiements initiaux de grands modèles de langage, ce qui nécessitera une planification architecturale pour des capacités de mise à l'échelle et d'extension massives.

Désagrégation de l'IA d'entreprise: l'écosystème MVLink Fusion permet une flexibilité sans précédent dans la construction de systèmes d'IA hétérogènes, accélérant potentiellement l'adoption d'accélérateurs d'IA spécialisés tout en maintenant la position de NVIDIA dans l'écosystème grâce à la technologie d'interconnexion.

Passer des centres de données aux usines d'IA: Nous devons complètement repenser la façon dont nous mesurons la valeur de nos investissements dans l'infrastructure. L'époque où la capacité brute de calcul ou de stockage était révélatrice est révolue. Aujourd'hui, tout est question de production de jetons : combien d'unités d'IA vos systèmes peuvent-ils générer par seconde, par watt et par dollar ? M. Jensen ne plaisantait pas lorsqu'il a déclaré que les entreprises rendraient bientôt compte de leur production de jetons, à l'instar des mesures de fabrication. Le passage aux usines d'IA va fondamentalement réécrire l'économie de la façon dont nous déployons et justifions les dépenses d'infrastructure de l'IA.

Intégration des jumeaux numériques: Le fait que tous les grands fabricants taïwanais construisent des jumeaux numériques Omniverse nous dit tout ce qu'il faut savoir : il ne s'agit plus d'une simple démonstration technologique. Les jumeaux numériques sont devenus une infrastructure essentielle pour les entreprises soucieuses d'optimisation. Ce qui est particulièrement fascinant, c'est la façon dont cela crée une boucle de rétroaction : les entreprises construisent des jumeaux numériques pour optimiser les processus physiques, puis utilisent ces mêmes environnements pour former l'IA et la robotique, ce qui améliore encore le monde physique. Il s'agit d'un cycle d'amélioration continue qui ne cesse de s'accélérer.

Planification de la main-d'œuvre robotisée: La convergence de l'IA agentique et de la robotique physique suggère que les organisations devraient développer des stratégies intégrées d'automatisation numérique et physique, avec des implications significatives pour la planification de la main-d'œuvre et la conception des installations.

Infrastructure définie par logiciel: Malgré les annonces de matériel, l'accent mis par NVIDIA sur les bibliothèques et les cadres logiciels renforce l'idée que l'avantage concurrentiel dans le domaine de l'IA viendra autant de l'optimisation logicielle que des capacités matérielles brutes.

Naviguer dans la transition de l'usine d'IA

La transformation des centres de données traditionnels en usines d'IA nécessite une expertise spécialisée qui fait le lien entre le déploiement du matériel, l'optimisation des logiciels et la conception architecturale. Chez Introl, nous avons mis en œuvre ces solutions d'infrastructure GPU avancées. solutions d'infrastructure GPU pour les entreprises qui se lancent dans l'informatique AI-first. L'expérience approfondie de notre équipe avec l'écosystème de NVIDIA - des déploiements complexes de MVLink aux implémentations de jumeaux numériques Omniverse - aide les entreprises à naviguer dans ce changement de paradigme sans la courbe d'apprentissage abrupte généralement associée à une infrastructure de pointe. Qu'il s'agisse d'augmenter les capacités de raisonnement de l'IA ou de construire votre première usine d'IA, le partenariat avec des spécialistes peut accélérer considérablement votre temps de retour sur investissement dans ce paysage en évolution rapide. Prêt à passer à l'action ? Appelez-nous dès aujourd'hui.

Conclusion : La troisième ère de l'informatique est arrivée

Le Computex n'a pas seulement été l'occasion pour NVIDIA de présenter des puces plus rapides. Ce que Jensen a présenté a dépassé les annonces habituelles du type "20 % de mieux que l'année dernière" auxquelles nous nous sommes habitués. Il recadre fondamentalement la fonction des ordinateurs. Nous avons passé des décennies à construire des machines qui calculent des chiffres et déplacent des données. Aujourd'hui, NVIDIA construit des systèmes dont le principal résultat est la fabrication d'intelligence. C'est comme comparer un classeur à un cerveau. Certes, les deux stockent des informations, mais l'un reste en place tandis que l'autre crée de nouvelles idées. Ce changement peut sembler sémantique jusqu'à ce que l'on se rende compte qu'il change tout dans la façon dont nous construisons, déployons et mesurons les systèmes informatiques.

"Pour la première fois depuis que nous sommes ensemble, non seulement nous créons la prochaine génération de technologies de l'information, mais nous l'avons fait à plusieurs reprises, du PC à l'internet, du nuage au nuage mobile. Nous l'avons fait à plusieurs reprises. Mais cette fois-ci, non seulement nous créons la prochaine génération de technologies de l'information, mais nous créons aussi un tout nouveau secteur.

Cette transition représente le troisième grand changement de paradigme informatique, après la révolution de l'informatique personnelle et l'ère de l'internet/du nuage. Les organisations qui intègrent ces capacités d'infrastructure d'IA sont susceptibles d'acquérir des avantages concurrentiels insurmontables dans tous les secteurs d'activité.

Les usines de l'intelligence informatique sont en construction aujourd'hui. La question n'est plus de savoir si l'IA va transformer les entreprises, mais si votre organisation met en place l'infrastructure nécessaire pour rester compétitive dans un monde où l'intelligence informatique devient aussi fondamentale que l'électricité pour le fonctionnement des entreprises.

Références et ressources complémentaires

Aperçu officiel de l'architecture Blackwell de NVIDIA : https://www.nvidia.com/en-us/data-center/technologies/blackwell-architecture/

Documentation technique NVIDIA MVLink : https://developer.nvidia.com/mvlink

Plate-forme NVIDIA Omniverse : https://www.nvidia.com/en-us/omniverse/

Plate-forme robotique Isaac : https://developer.nvidia.com/isaac-ros

NVIDIA AI Enterprise : https://www.nvidia.com/en-us/data-center/products/ai-enterprise/

Matériel de presse officiel de NVIDIA Computex 2025 : https://nvidianews.nvidia.com/news/computex-2025

Présentation des bibliothèques NVIDIA CUDA-X : https://developer.nvidia.com/gpu-accelerated-libraries

Systèmes NVIDIA DGX : https://www.nvidia.com/en-us/data-center/dgx-systems/